Es ist wichtig zu verstehen, dass die Suchmaschinen, in dem Moment wenn eine Anfrage gestellt wird, nicht Just-in-time das Internet nach passenden Treffern durchsuchen, sondern auf die Informationen zugreifen, die davor gesammelt, indexiert und auf den Suchvorgang vorbereitet waren. In diesem Kapitel erfahrt man über Suchmaschinen Funktionsweise, Crawler (Spider) und Suchmaschinen Algorithmen.

„Diplomarbeit SEO Strategien“ Inhaltsverzeichnis

Wie funktionieren Suchmaschinen?

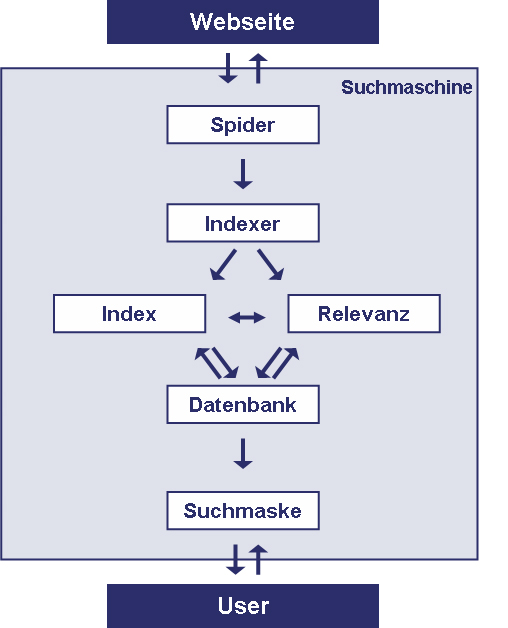

Abb. 5 Funktionsweise der Suchmaschinen. Quelle: https://www.marketing.ch/wissen/suchmaschinenmarketing/funktion.asp

Eine Suchmaschine besteht, sehr grob eingeteilt, aus drei großen, für verschiedene Prozesse verantwortlichen Modulen:

- 1.Crawler / Spider

- 2.Indexer / inverser Index

- 3.Suchmaske / User Interface / Suchalgorithmus / Ausgabe

Crawler

1. In gewissen Abständen scannen die Suchmaschinen das Internet, die Webseiten und deren Inhalte. Das ist die Aufgabe eines Crawlers. Der Crawler kommt in unregelmässigen Abständen und durchforstet Websites, das kann man nicht beeinflussen.

Je „stärker“, interessanter eine bestimmte Website für die Suchmaschine erscheint, desto häufiger schaut der Crawler vorbei. Das kann man sehr wohl beeinflussen.

Zum Beispiel werden die Webseiten bekannter Zeitungen und anderer vertrauenswürdiger Quellen mehrmals täglich aktualisiert und dementsprechend vom Crawler mehrmals täglich erfasst.

Es ist sehr wichtig zu verstehen, dass die Suchmaschinencrawler eine Website “mit den anderen Augen“ sehen, als die Websurfer.

Eine Website, die für das menschliche Auge gut aussieht und lesbar ist, kann für die Suchmaschinen unzugänglich sein. Suchmaschinen können zum Beispiel keinen Text auf den Bildern lesen, kein Flash, oder nur sehr begrenzt, und auch keine Java Scripts (javascript) erfassen.

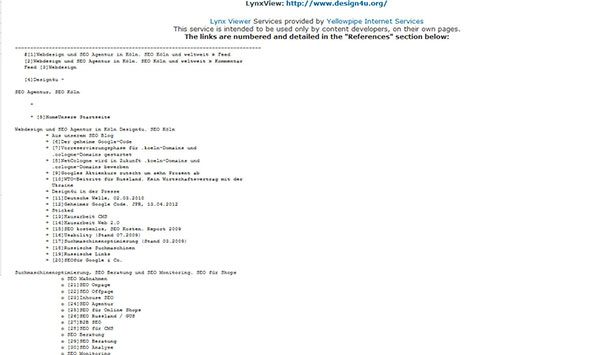

Möchte man herausfinden, was die Suchmaschine beim Crawlen einer Website sieht, verwendet man einen textbasierten Browser. Am bekanntesten ist wohl der Lynx15 , mit welchem eine Website aus Suchmaschinensicht betrachtet werden kann.

Abb. 6 https://www.design4u.org/ aus der Websurfer Sicht

Abb. 7 https://www.design4u.org/ aus der Suchmaschinensicht. Quelle: Lynx Browser online – https://www.yellowpipe.com/yis/tools/lynx/lynx_viewer.php

Es gibt mehrere bekannte für den Crawler schlecht bzw. überhaupt nicht lesbare Elemente. Möchte man also einem Crawler erst ermöglichen, auf eine Seite optimal zu zugreifen, sollte man folgende Programmiertechniken vermeiden:

- – Flash Seiten

- – Frames

- – Links mit Sessions-ID’s in der URL

- – Links in Java-Script oder in Flash

- – Clientseitige Redirects

Google Caffeine

Seit März 2010 indexiert Google Twitter, einige weitere Soziale Netzwerke, Microblogging Dienste, Blogosphäre und Blogs in Echtzeit14. Google führte Anfang 2010 mehrere neue Suchtechnologien ein. Diese erlauben eins: eine gewaltige Menge an Dokumenten wesentlich schneller als früher auf Aktualisierungen hin zu prüfen und mehrere Änderungen zu den relevanten Suchergebnissen für die Nutzer schneller zu präsentieren.

Im Grunde laden Crawler das Internet herunter. Larry Page, einer der beiden Gründer von Google ging noch vor der Google-Ära zu seinem Professor und sagte: “Ich werde das Internet herunterladen. Und ich werde es besser machen als AltaVista.“ Das hat er erfolgreich umgesetzt.

Indexer

2. Die Indexer untersuchen die von Crawlern gewonnenen Daten nach Keywords und weiteren Kriterien und ordnen diese in einem inversen Index. Ein inverser Index ist eine Struktur, in welcher bestimmte Suchbegriffe den entsprechenden Dokumenten zuordnet werden. Umgekehrt verweisen invertierte Dateien auf die Suchbegriffe, mit welchen sie verknüpft sind. Es werden also Listen von Seiten geführt, welche Schlüsselbegriffe besitzen. Dieser Index ist somit die Grundlage für die Suchergebnisse – Ergebnisse der Suchanfragen.

Suchergebnisse

3. Die Reihenfolge der Suchergebnisse ist aber nicht von Anfang an im Index festgelegt, sondern wird für jede Suchanfrage „individuell“ erstellt.

Der Suchalgorithmus untersucht die im Index gefundenen Webseiten auf verschiedene Kriterien wie z.B.:

- – Quellcode

- – Keyworddichte

- – Linkpopularität

und legt somit fest, welche Webseiten für welche Suchbegriffe „relevanter“, passender sind. Man spricht von über 200 Kriterien, die z.B. Google zur Bewertung von Webseiten verwendet. Alle diese Kriterien und deren verschiedene Gewichtungen machen den so genannten Suchalgorithmus aus und legen somit die Reihenfolge der Suchergebnisse für den jeweiligen Suchbegriff fest.

Suchmaschinen Algorithmen

Diese Algorithmen sind patentiert und überhaupt das bestgehütete Geheimnis der Suchmaschinen. Die Algorithmen werden ständig abgeändert und angepasst, mit den Filtern und bestimmten Logiken versehen. Verschiedene Suchalgorithmen sind ein Grund für unterschiedliche Suchergebnisse bei verschiedenen Suchmaschinen.

Wie funktioniert Suchmaschinenoptimierung. SEO-Guide 2023

Wie funktioniert Suchmaschinenoptimierung. SEO-Guide 2023  MUM, der neue Algorithmus von Google

MUM, der neue Algorithmus von Google  BERT – Google’s Algorithmus für besseres Sprachverständnis

BERT – Google’s Algorithmus für besseres Sprachverständnis  SEO: Wie optimiert man Landing Pages?

SEO: Wie optimiert man Landing Pages?

Hinterlasse als Erster einen Kommentar